金赢中心

金赢中心

数字计算主导了计算机世界这么多年,现在终于出现了一种新路径,能在速度和能耗上大幅超越它。

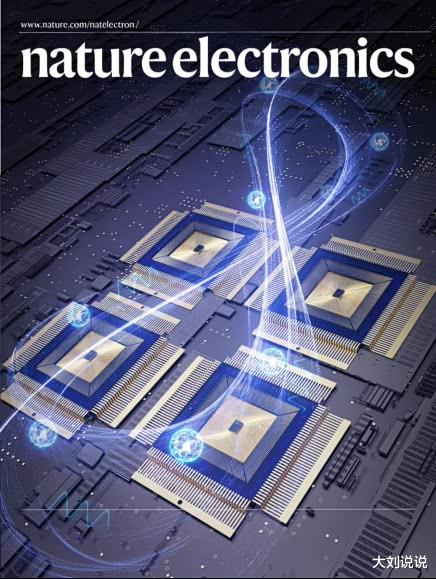

北京大学人工智能研究院的孙仲团队,联合集成电路学院的研究者们,开发出一款基于阻变存储器的模拟矩阵计算芯片。这项工作把模拟计算的精度推到了24位定点水平,解决了这个领域长达一个世纪的难题。

性能测试显示,在处理大规模MIMO信号检测这类科学问题时,它的计算吞吐量和能效,比顶尖的图形处理器高出百倍到千倍。成果已经在《自然·电子学》上发表,这不只是技术进步金赢中心,还为人工智能和6G通信领域的算力瓶颈提供了新出路。

传统计算机和GPU靠0和1的数字运算,精确度高,但遇到复杂数学任务,就显得慢而耗电。模拟计算不同,它直接借用电路的物理特性得出结果,速度快,能耗低,可惜精度一直跟不上。

现在的电脑在处理通用任务如上网或游戏时,数字方式占优。但在高密度矩阵运算上,模拟计算的潜力巨大。北大团队的创新在于一个内部迭代校正机制:先用低精度电路快速得出粗略答案,再用高精度电路计算误差,这个误差反馈回去修正初始结果。重复几次,精度就大幅提升。实验中,解一个16x16矩阵,10次迭代后,相对误差降到千万分之一,相当于32位浮点数字计算的水平。

实际应用上金赢中心,这个芯片在6G通信的MIMO信号检测中表现突出。这是基站处理信号的核心瓶颈,只需迭代3次,就能达到高精度数字处理器的效果,误码率完全一致。吞吐量超过顶级GPU千倍,能效高百倍以上。这意味着在特定场景下,计算资源能更高效利用,避免大量能源浪费。

这项突破放在后摩尔时代背景下,更有意义。摩尔定律接近物理极限,芯片工艺难再缩小,人们开始探索新计算范式。从搜索到的信息看,除了模拟计算,量子计算和光计算也在推进。量子计算擅长并行处理复杂优化问题,但目前受噪声和稳定性限制,还不成熟。光计算用光信号传输数据,速度极高,能耗低,已在一些数据中心测试中显示潜力。异构芯片则结合不同处理器类型,提升整体效率。这些路径各有侧重,模拟计算的优势在于对矩阵运算的专长,尤其适合人工智能训练中的线性代数操作。

人工智能领域正面临巨大能源挑战。训练大型模型如GPT系列,需要海量电力,全球数据中心能耗已占总电量的2%以上。6G网络目标是实现超低延迟和海量连接,但集成AI后,能源消耗会进一步上升。资料显示,AI能优化6G的资源分配,减少浪费,但自身计算也加重负担。

北大芯片的模拟方法,能在边缘设备上高效运行AI推理,降低整体能耗。想象一下,在智能电网或自动驾驶中,这种芯片处理实时信号检测,不用依赖云端,就能节省大量电力。这不只技术层面,还涉及可持续发展:减少碳排放,支持绿色计算。

我的看法是,这项工作可能开启混合计算时代。未来系统或许数字部分管通用逻辑,模拟部分专攻高强度数学。结合RRAM技术,这种芯片在40nm工艺上已实现高精度,扩展性强,能集成到现有生产线。相比量子计算的昂贵冷却需求,模拟计算更易推广。

6G标准制定中,如果纳入类似架构,网络效率能提升一个台阶。但挑战在于通用性不足,目前只适合特定任务。长远看,它推动计算从纯数字转向多元范式,缓解AI爆炸式增长带来的能源危机。

总的来说,这个芯片证明了改变计算原理金赢中心,能带来飞跃式进步。它不取代现有电脑,而是补充关键短板。在人工智能和通信迅猛发展的今天,这样的创新至关重要,帮助我们应对算力短缺。希望更多研究跟进,让这些技术尽快落地。

红腾网提示:文章来自网络,不代表本站观点。